Task02-大模型的能力

✍内容

项目地址:第2章 大模型的能力 (datawhalechina.github.io)

本章主要讨论了GPT-3这个大语言模型的能力,讨论关于对GPT-3的基准测试,其中包括问题回答和在句子中使用新词。再对比每一个最新技术成果时,发现GPT-3的结果参差不齐有的超越了现有的最高水平有的还有落后。

下面来总结一下通过本章学习学到了什么?

🖊总结

首先讲了语言模型的适应性

1.从语言模型到任务模型的转化

我们上一章节知道语言模型p是一种对token序列 x_{1:L}的分布,这种模型可以用于评估序列也可以用于在给定提示的条件下生成完整的序列。

那么如何从语言模型转化为任务模型呢?

我们用"适应(Adaptation)"来指代这个转化过程,这个过程需要两个输入:

任务的自然语言描述

一组训练实例(输入-输出对)

通过两种方式来进行这种适应,这个在项目里面都有介绍。

这种适应其实就是通过给语言模型标准答案,在语言模型中形成一种题库,当你提出问题时他会提取你问题的关键局,从题库中查找出最合适的答案,翻译就是一个很好的例子。

本章中讨论GPT-3在大量任务上的表现的一部分:

定义:任务是什么,以及其动机?

适应:我们如何通过提示将任务简化为语言模型?

结果:与该任务的最先进模型相比,

GPT-3的定量性能如何?

实验的任务选择如下:

Language modeling(语言建模)

Question answering(问题回答)

Translation(翻译)

Arithmetic(算数计算)

News article generation(新闻文章生成)

Novel tasks(新任务)

2.Language modeling(语言建模)

在这一小节中讲了困惑度(Perplexity)是一个用来衡量语言模型的重要指标,通过这个指标比较了算术平均和几何平均更倾向于哪一个以及两者的区别。

其中困惑度被定义为: P(X) = P(x_1,x_2,...,x_N)^{(-1/N)}

几何平均公式为:

其中提到了分支因子(branching factor),他可以理解为在每个位置,模型认为有多少种可能的词会出现。分支因子与公式中的\log \frac{1}{p\left(x_i \mid x_{1: i-1}\right)}密切相关,这个表单书代表了编码长度,我们通过对平均编码长度取指数,可以得到选择数量也就是"分支因子"。

还提到了语言模型可能会烦的两种错误以及困惑度对两种错误的处理方式。

接下来举了几个实际数据集评估出来的困惑度的例子:

Penn Tree Bank(适应性测试评估其困惑度)

LAMBADA(预测句子的最后一个词)

HellaSwag(从一系列选择中选出最适合完成句子的选项)

3.Question answering(问题回答)

这个是(闭卷)问答题,其中输入是一个问题,输出是一个答案。语言模型必须以某种方式“知道”答案,而无需在数据库或一组文档中查找信息。

其中例子包括:

TriviaQA(给定一问题后生成答案)

WebQuestions(和TriviaQA类似是问答任务)

NaturalQuestions(回答问题)

4.Translation(翻译)

翻译任务是将源语言中的句子翻译成目标语言中的句子。

这种翻译任务需要大量的语料库而且翻译的结果的差异性由你是什么语言模型决定。

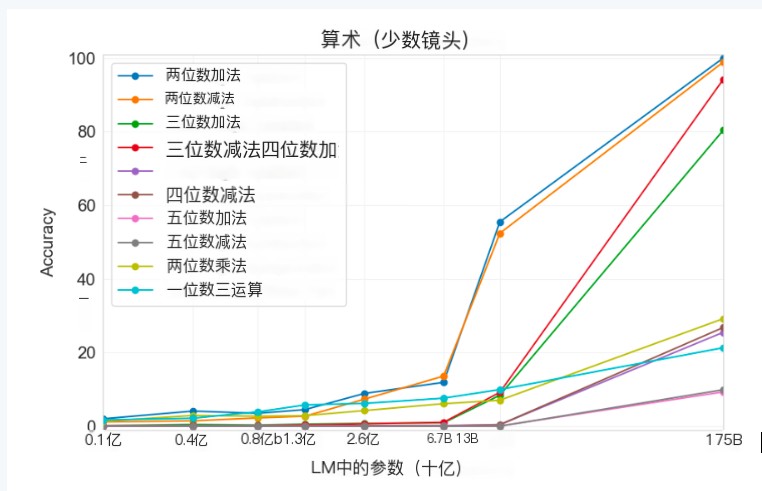

5.Arithmetic(算数计算)

这里的Arithmetic任务是做算术题(2-5位数的加法,减法,乘法)。

通过对结果的分析效果还是不错的。

6.News article generation(新闻文章生成)

目标: 给定标题和副标题,生成新闻文章。

在这里设立了一个评估标准,人类根据文章可能由机器编写的可能性对文章进行评分。

结果:人类只有52%的时间能够正确地分类“人类”与“机器”(几乎只是随机机会)。

7.Novel tasks(新任务)

其中包括:

使用新词(给定一个新造的词和定义,生成使用该词的句子)

纠正英语语法(给定一个不合语法的句子,生成其合语法的版本)

这里展示里两种新任务的结果实例。

通过本章的学习了GPT-3在处理NLP任务的能力,发现GPT-3在处理这些任务中确实做的不错。

- 感谢你赐予我前进的力量